A l’occasion de cette quatrième séance, le séminaire Jourdain a reçu deux intervenants : Benjamin Gans, ingénieur Recherche et Développement et responsable Communication et Marketing chez Data Publica, société spécialisée dans le développement de « jeux de données » et Fabrice Rochelandet, économiste à l’université Paris III Sorbonne Nouvelle dont les travaux portent notamment sur « l’économie des données personnelles ».

L’objectif de cette rencontre consistait à explorer et questionner les enjeux démocratiques soulevés par le « datajournalisme » : quelle représentation du rôle des journalistes en démocratie se dessine derrière la promotion des « données » ? Comment s’exprime, à travers un imaginaire du journalisme, une réflexion sur la représentation politique ?

Les données personnelles en question

Fabrice Rochelandet est intervenu dans un premier temps. Auteur d’un ouvrage intitulé « Économie des données personnelles et de la vie privée », il étudie ce qu’il nomme le « fétichisme de la donnée ».

Il a rappelé que la liberté d’informer est à penser en lien avec la liberté des données personnelles. Il propose d’envisager, dans la longue durée, le travail de la presse (et du numérique) comme travail des données personnelles.

Il a donné pour exemple la peopolisation en soulignant qu’il ne s’agit nullement d’un phénomène récent mais bien plus d’une « vieille question » qui remonte à l’invention de la photographie de presse et qui a pu s’incarner aussi, ensuite, dans la pratique d’investigation consistant à aller chercher des « données » dans les poubelles par exemple.

Poussant plus loin la démarche, il propose d’analyser l’implication des données dans la « peopolisation de la vie ordinaire », les données sont alors envisagées comme « traces laissées derrière soi ». Elles peuvent être mobilisées comme outils dans le cadre d’étude des comportements individuels dans le sens où elles peuvent permettre de comprendre des comportements paradoxaux. Ce qui implique aussi de poser la question de la distinction entre ce qu’on dévoile de soi (données ex-ante) et ce qui est dévoilé par les autres (opérateurs – publicité ciblée) (données ex-post).

Investigation des données personnelles dans le monde par les programmes de surveillance américain (NSA)

Cette démarche met en lumière le rôle des données (et du médiatique) dans la construction des catégories désignant les personnalités comme people / publiques / politiques, dont les frontières sont loin d’être étanches.

Rochelandet pose la question de la construction de l’identité numérique. A son sens, celle-ci a à voir avec un processus de « décloisonnement des espaces sociaux de l’individu », phénomène qui conduit à la perte du monopole de la connaissance de soi et à une « illusion de contrôle ». Il propose, pour qualifier ce phénomène, la notion de « vie privée informationnelle » qui repose aussi la question de la distinction entre secret/privé et des frontières de l’intimité.

Son intervention s’est achevée sur une réflexion autour du flou entourant la définition de ce que sont les « données publiques » avec l’ambivalence du terme public qui peut désigner à la fois ce qui est rendu public comme ce qui est connu de tous car publié. Ainsi, les médias ne cessent d’en redéfinir les frontières.

Un exemple d’intermédiaire : Data Publica

Benjamin Gans est intervenu dans un second temps pour présenter l’agence Data Publica.

L’origine de celle-ci remonte à 2010, elle s’inscrivait alors dans le cadre d’un projet de recherche financé par le Ministère de l’Économie et données publiques en 2010. Il s’agissait de procéder au référencement des données publiques à partir des différents fichiers rendus disponibles par l’administration publique (2500 fichiers alors pour plus de 15 000 aujourd’hui). Elle avait alors pour concurrent direct le site datagouv.fr.

Au départ, l’équipe envisageait l’agence comme un « data-store » dans lequel les éditeurs privés seraient venus piocher. Comme le projet tel quel n’a pas fonctionné, un service de données « sur mesure » a été mis en place. Data Publica est alors partie du postulat que « les sociétés ont besoin de données » mais n’ont pas connaissance de ce qui existe en Open Data.

Le credo de datapublica : les entreprises ont besoin de données

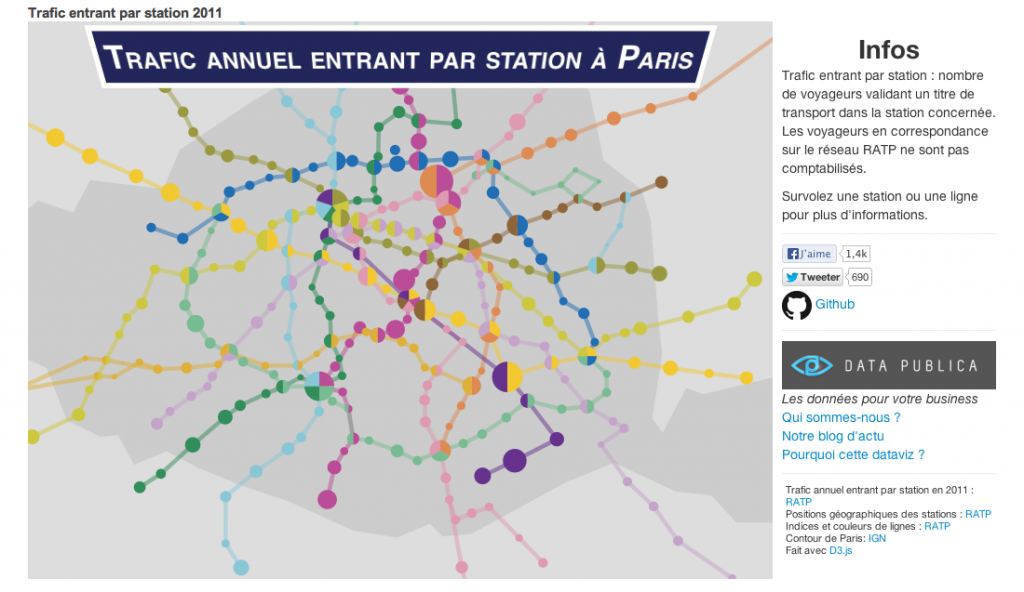

Aussi, eux proposent une automatisation de l’extraction pour les éditeurs qui produisent et publient des données (« qui font de l’Open Data sans le savoir »), développent des tableaux de bord à leur attention et mettent en place des outils de visualisation « à partager » (cartes, courbes, histogrammes, tableaux…). Leurs clients sont notamment des cabinets de conseil, il donne l’exemple de la réalisation d’un tableau de bord des zones d’emploi en France ou d’une carte du patrimoine immobilier de l’Etat.

En parallèle leur visée a aussi été, dans un « moment expérimental » de l’agence, de montrer que les données « ont de la valeur » en produisant des articles et en faisant connaître, à travers le travail des datajournalistes, la manière dont la donnée peut être « mise en scène ». Ils se placent ainsi en position de double intermédiaire : entre l’État et le citoyen, entre les journalistes et leurs lecteurs (médiateur de la médiation journalistique).

Concernant l’exposé de la méthode employée dans une démarche datajournalistique, Benjamin Gans expose qu’il existe des données disponibles, à nettoyer et à manipuler pour « faire sortir l’information ». Il souligne qu’il s’agit d’un « travail d’équipe » (développeur, journaliste, informaticien, statisticien) : « Il est possible d’en faire seul mais souvent les journalistes n’ont pas la maîtrise parfaite des outils. »

A ses yeux, il existe deux cas de figure majeurs impliquant une démarche de ce type : soit un fichier inédit à interpréter, soit la fouille de fichiers très volumineux. Ce qui implique aussi de faire la différence entre « Data » et « Big Data » : cette seconde dénomination désigne des volumes d’information exponentiels et incommensurables, qui ne peuvent être seulement traités par l’humain. A celui-ci revient toutefois de résoudre la question de comment on les gère et comment on les utilise. En effet, il rappelle que « Big Data » est évolutif et pose à ce titre des problèmes de stockage.

Plus largement, il parle du phénomène de l’Open data comme d’une « révolution » pour les données. Avec le basculement de données dans le domaine public, on est face à un gisement à exploiter, qui repose question de la transparence. En écho aux propos de Fabrice Rochelandet, il explique qu’à leur niveau on retrouve la déclinaison privé/public sous la forme business/État.

Les autres tournants identifiés par lui sont notamment OWNI, les productions d’Alexandre Léchenet pour lemonde.fr), et l’entreprise collective de Wikileaks. C’est à ce moment là, dit-il, qu’on redécouvert la possibilité de l’investigation avec les chiffres.

Benjamin Gans a clôturé son intervention en revenant sur le contenu de son activité d’enseignement au CELSA. Il a détaillé ce qu’il apprend aux étudiants et qu’il voit comme des prérequis à toute bonne activité datajournalistique : la manipulation de la donnée via Excel et les outils de visualisation (Google Charts, Many Eyes, Datawraper etc.). Ceux-ci permettent une visualisation très simple et « ça c’est du datajournalisme ». Mais, il ne s’agit pas non plus d’être uniquement dans la visualisation : la contextualisation est nécessaire en plus de la dimension esthétique et du « storytelling par l’image ».

Nom | Création | Type de logiciel | Éditeur | Type de visualisation | Utilisation |

|---|---|---|---|---|---|

| VIDI | ? | Application web | Jefferson Institute | Graphiques | |

| Many Eyes | 2007 | Application web | IBM | Graphiques | |

| Infovis | 2008 | Bibliothèque javascript | Communauté open source | Graphiques animés | |

| Gephi | 2008 | Application bureau | Communauté open source | Réseaux sociaux | |

| R | 1993 | Code spécifique | Communauté open source | Graphiques | |

| Highcharts | 2009 | Application Web | Highcharts solution AS | Graphiques animés | OWNI |

| Google Maps | 2004 | Application Web | Cartographie | OWNI, AFP, Rue89… | |

| Kartograph | 2011 | Framework Python et Javascript | Gregor Aisch | Cartographie | Journalism++ |

Sélection des outils de visualisation par le projet jourdain

Il apprend également aux étudiants à identifier des « sources de données », à acquérir des réflexes en la matière — aller consulter opendataparis en est un exemple, à réfléchir sur nouveaux modes de lecture. Il souligne à ce propos l’aspect plus interactif des productions « data » et tisse un lien entre mobilité et nouvelles lectures, par la dimension tactile des nouveaux supports « on va pouvoir entrer dans la donnée », dans les différentes strates, avec, en prime, un effet ludique.