Le « Data Journalisme » n’est plus qu’une expression à la mode : une petite décennie nous sépare l’article original d’Holovaty, A Fundamental Way Newspaper Need To Change, publié initialement en septembre 2006. Depuis lors, le terme a fédéré une importante communauté professionnelle, structurée par des projets emblématiques, des associations, des espaces d’échanges, des ressources éducatives, et, même, un manuel de référence (le Data Journalisme Handbook). Le mouvement ayant atteint une forme de maturité, il devient tentant d’en rédiger l’histoire…

Le rapport d’Alexandre Léchenet, Global Database Investigations: The role of the computer-assisted reporter s’inscrit dans la perspective d’une évaluation rétrospective : que s’est-il passé pendant ces dix dernières années ? Le parcours de Léchenet résume parfaitement le processus d’institutionnalisation du mouvement : il participe initialement à l’aventure OWNI, avant de rejoindre des titres de référence de la presse française, le Monde puis, depuis peu, Libération.

Pour autant, le rapport ne se présente pas comme un témoignage. Léchenet propose une analyse élaborée et distancée d’un phénomène auquel il a directement participé, en tentant de cerner l’influence de facteurs jusqu’ici relativement ignorés, telles que la mondialisation de l’enquête journalistique. Depuis les années 1990, il devient en effet difficile de se restreindre au seul espace national. L’harmonisation des législations (sous l’effet d’organisations supra-nationales, comme l’Union Européenne ou l’OMC), l’émergence d’une société de l’information globalisée (avec l’avènement des nouveaux médias) et la dérégulation des échanges : tous ces processus conjoints concourent à saisir l’actualité par-delà les frontières. Or, les rédactions restent fortement localisées : l’immense majorité des journaux revendiquent un attachement à un territoire précis. Il n’en a pas toujours été ainsi. On assiste ainsi à l’émergence d’un journalisme francophone international au cours du XIXe siècle, grâce à l’absence de toute restriction liée à la propriété intellectuelle (les articles de presse appartenaient de facto dans un domaine public vivant).

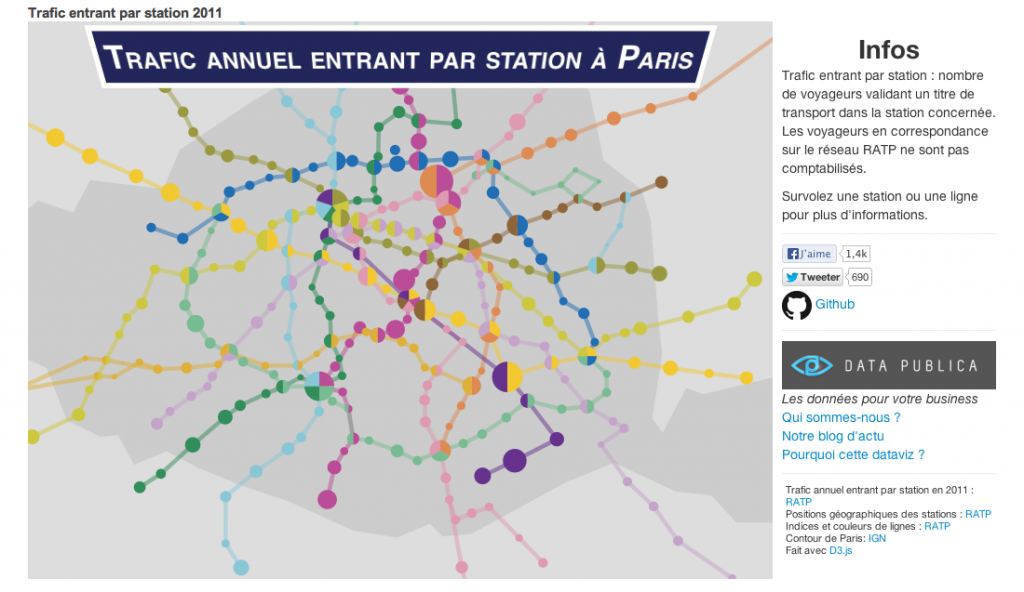

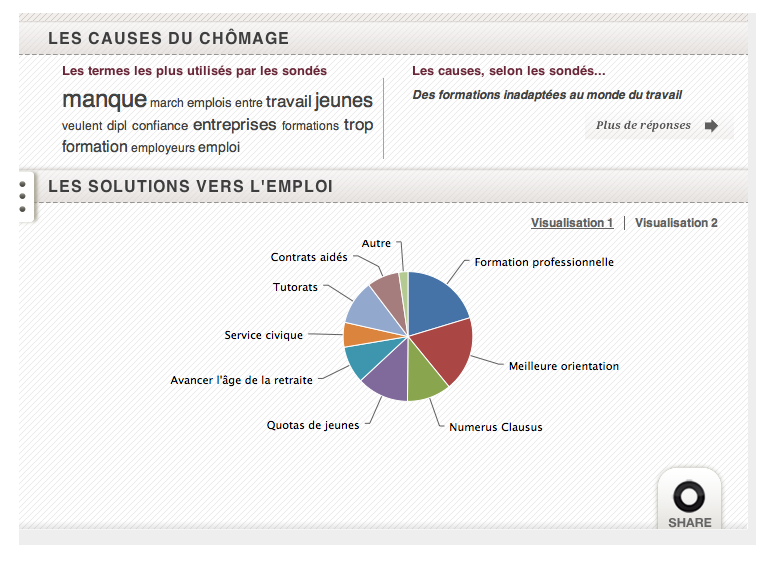

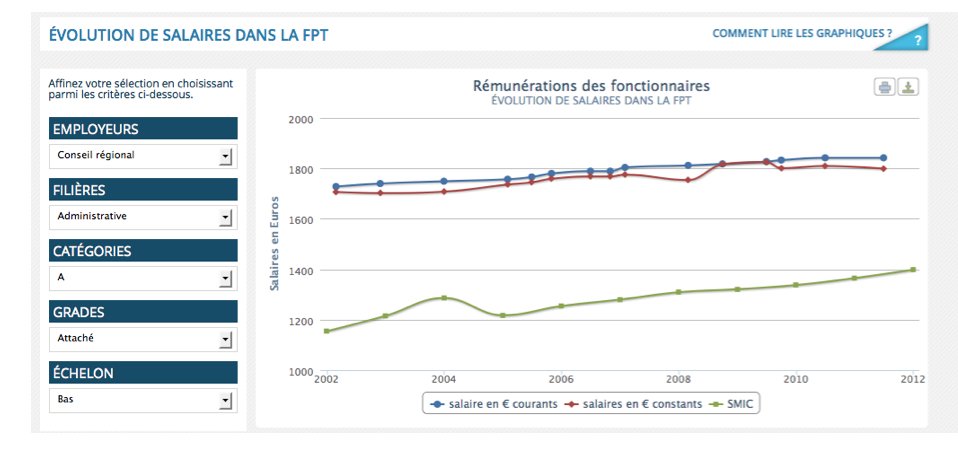

Les outils numériques permettent de satisfaire ces besoins préexistants. Ils ne facilitent pas seulement le stockage et l’indexation de vastes volumes de données, mais autorisent des collaborations intensives à distance. Les trois case studies présentées par Léchenet s’inscrivent toutes dans cette configuration : le traitement de vastes problématiques transnationales est rendu possible par la création et l’utilisation de grandes bases de données collaboratives.

Farmsubsidy prend forme dès 2005 (soit avant même l’apparition du terme « data journalisme »). Le projet s’apparente initialement à une collecte informelle d’informations sur le financement de la Politique Agricole Commune. Les bénéficiaires de ce plan européen très coûteux (50 milliards d’euros par an) restent en effet inconnus. Néanmoins, plusieurs pays européens (comme le Danemark) avaient mis en place des procédures d’accès à l’information (on parle aussi de Wobbing, dans le jargon datajournalistique). Graduellement, le projet prend de l’ampleur. Il s’intitule aujourd’hui « Data Harvest » et a diversifié ses activités de récolte de données bien au-delà

Farmsubsidy reste cependant une forme de collaboration relativement lâche, qui se limite à la mise en commun d’informations obtenus au quatre coins de l’Union Européenne. Les Offshore Leaks se caractérisent par une intégration beaucoup plus poussée. Un consortium d’une centaine de journalistes issu de 47 pays est créé, quinze journalistes se consacrant exclusivement au « nettoyage » des données. La divulgation des révélations fait l’objet d’une coordination internationale, afin d’en renforcer l’impact.

Le troisième projet, les Migrant files, se constitue avec le soutien d’organisations internationales. Les informations recueillies sont fréquemment utilisées par Amnesty International ou l’Office de l’immigration : « c’était la base données la plus complète disponible sur le sujet » (p. 24).

Le rapport de Léchenet explique ainsi le développement du data journalisme par les usages plutôt que par les idées : le data journalisme émerge presque spontanément dans le cadre de communautés de pratiques. Le travail sur la donnée constitue le terrain commun propice au rapprochement des rédactions et à la convergence des métiers et des expertises. L’élaboration de représentations collectives de ce que serait ou devrait être le data journalisme découle de ces expériences collaboratives, qui n’avaient initialement qu’un objectif très précis (par exemple recueillir des données sur la PAC).

Léchenet met également l’accent sur aspect du data journalisme que l’on tend à occulter : le classement documentaire. La donnée n’apparaît pas seulement la matière première d’une analyse statistique, visant à dégager corrélations et causations : elle constitue un objet éditorial qui doit être identifié, « nettoyé » et classé. La description des Offshore Leaks rend compte de la difficile construction d’un ordre documentaire, depuis l’extraction du texte (par OCR) jusqu’à la catégorisation des noms et des mouvements financiers concernés.

Enfin, le rapport s’interroge sur le développement d’une culture collaborative au sein du champ journalistique. Léchenet se fait l’écho d’une remarque ironique d’Emily Bell : « il n’y a rien que les journalistes n’aiment plus qu’apprendre à coder, si ce n’est collaborer les uns avec les autres… ». Les journaux restent en effet des entreprises en concurrences, les unes avec les autres : peut-on surmonter durablement l’état de méfiance instinctive entre tous les acteurs ?

L’utilisation croissante des outils open source et l’implication d’acteurs situés hors du champ journalistique (des associations au hacker solitaire) semble encourager ce nouvel état d’esprit : « La culture collaborative n’est pas inhérente à l’activité journalistique. Mais les techniques du computer-assisted reporting supposent souvent la collaboration des journalistes, soit avec les lecteurs, soit avec d’autres journalistiques et les repères culturels sont en train de changer. » (p. 25).